Vezi în acțiune

Puternic, dar simplu.

De la pipeline-uri personalizate de analiză la verificări mobile instant — didi se adaptează fluxului tău.

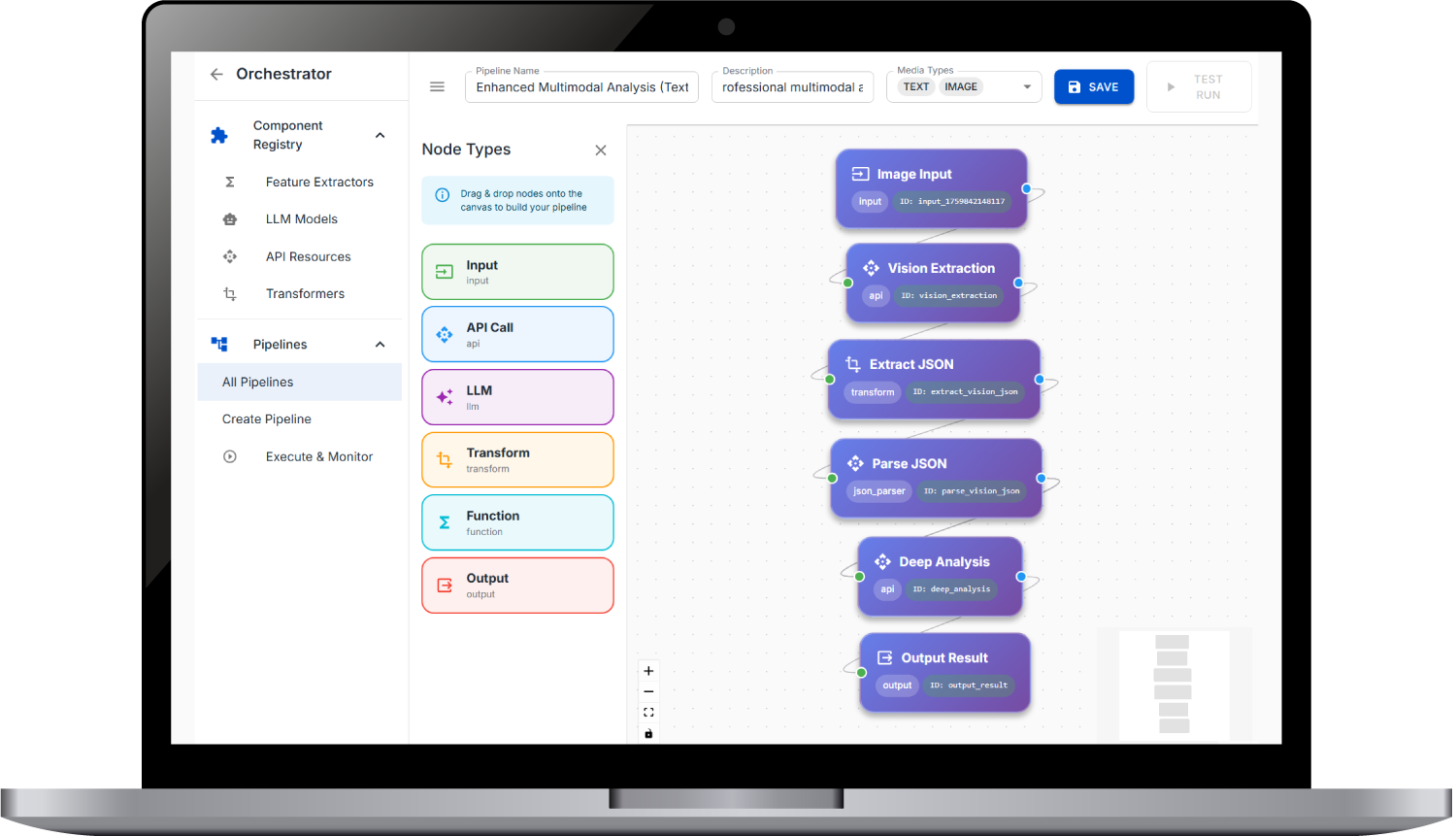

Pipeline-uri personalizate

Construiește workflow-uri dedicate pentru tipuri specifice de dezinformare.

Mobile first

Partajează din orice aplicație socială. Primești notificare când analiza e gata.

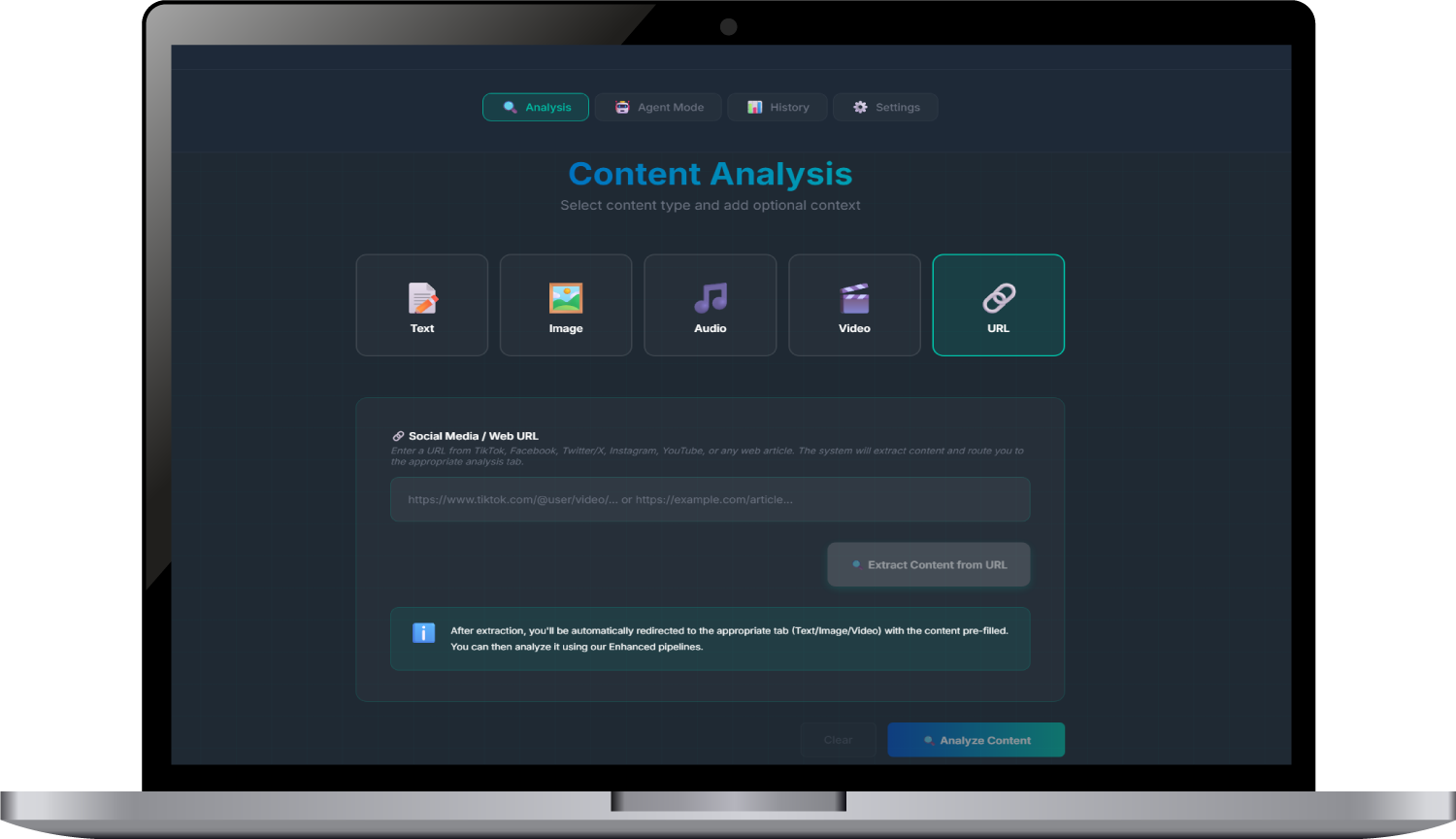

Multiple tipuri de input

Analizează imagini, text, link-uri, video — toate dintr-un singur dashboard.